环境信息

基础环境配置(三台都要配置)基本都是在部署机使用for循环来配置

vi /etc/hosts 127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4 ::1 localhost localhost.localdomain localhost6 localhost6.localdomain6 172.18.1.227 node1 172.18.1.228 node2 172.18.1.229 node3node1配置hostname

hostnamectl set-hostname node1node2配置hostname

hostnamectl set-hostname node2node3配置hostname

hostnamectl set-hostname node32、创建ssh密钥和免密登陆

部署机创建ssh密钥文件

ssh-keygen使用for循环拷贝密钥到各个节点,输入yes和root密码

for host in node{1..3};do ssh-copy-id $host;done

3、安全配置(关闭防火墙和selinux配置)这里使用for循环修改每一个节点for host in node{1..3};do systemctl stop firewalld;systemctl disable firewalld;setenforce 0;sed -i '/SELINUX/s/enforcing/disabled/g' /etc/selinux/config;done

4、时间同步服务器ntp配置for host in node{1..3};do yum install ntpdate -y;systemctl stop ntpdate;ntpdate cn.pool.ntp.org;done

5、配置yum源(epel、ceph)下载epel源到每个节点中

for host in node{1..3};do ssh $host wget -O /etc/yum.repos.d/epel.repo http://mirrors.aliyun.com/repo/epel-7.repo;done

创建ceph源cat >/etc/yum.repos.d/ceph.repo<<EOF [Ceph] name=Ceph packages for $basearch baseurl=http://mirrors.aliyun.com/ceph/rpm-nautilus/el7/$basearch enabled=1 gpgcheck=0 type=rpm-md [Ceph-noarch] name=Ceph noarch packages baseurl=http://mirrors.aliyun.com/ceph/rpm-nautilus/el7/noarch enabled=1 gpgcheck=0 type=rpm-md [ceph-source] name=Ceph source packages baseurl=http://mirrors.aliyun.com/ceph/rpm-nautilus/el7/SRPMS enabled=1 gpgcheck=0 type=rpm-md EOF不知道为啥,创建完没有$basearch,需要手动添加上

vi /etc/yum.repos.d/ceph.repo baseurl=http://mirrors.aliyun.com/ceph/rpm-nautilus/el7/$basearch分发ceph源到其他节点中

for host in node{1..3};do scp /etc/yum.repos.d/ceph.repo $host:/etc/yum.repos.d/;done重新加载yum缓存for host in node{1..3};do ssh $host yum makecache;done

6、部署机安装ceph-deployyum install ceph-deploy -y7、节点安装ceph、ceph-radosgw,这里使用for循环一起安装

for host in node{1..3};do ssh $host yum install ceph ceph-radosgw;done

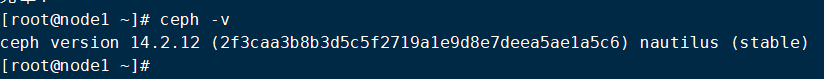

查看安装的版本

查看安装的软件

[root@node1 ~]# mkdir /cluster [root@node1 ~]# cd /cluster/ [root@node1 cluster]# ceph-deploy new node1 node2 node3

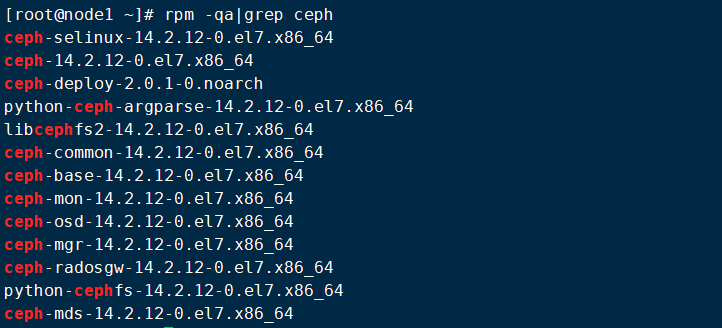

查看集群配置文件

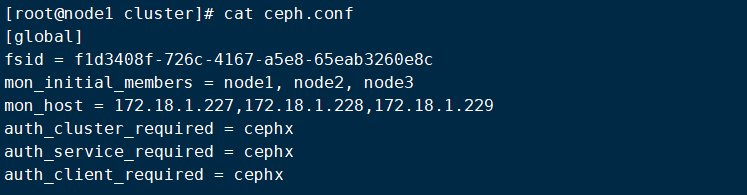

[root@node1 cluster]# ceph-deploy mon create-initial查看进程和监听

10、分发密钥到所有mon节点中

[root@node1 cluster]# ceph-deploy admin node{1..3}

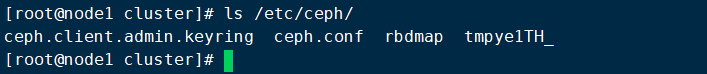

查看配置文件

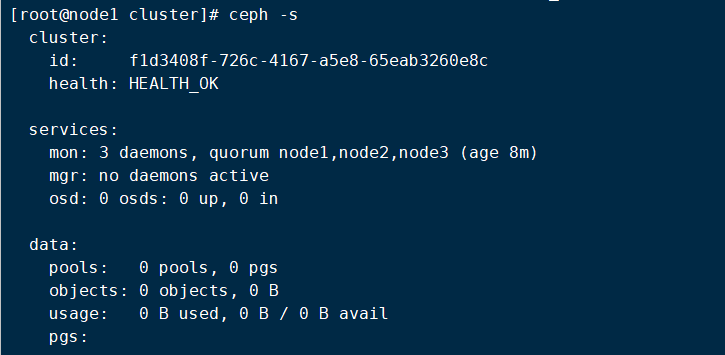

查看集群信息状态

11、创建mgr

11、创建mgr

[root@node1 cluster]# ceph-deploy mgr create node{1..3}

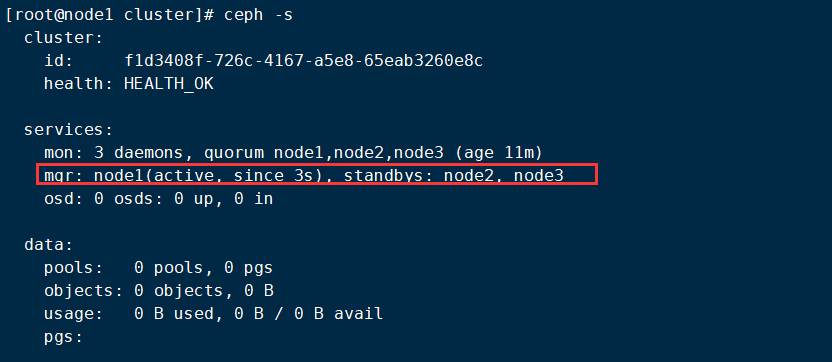

查看mgr集群状态信息

12、部署osd

[root@node1 cluster]# ceph-deploy osd create node1 --data /dev/sdb [root@node1 cluster]# ceph-deploy osd create node1 --data /dev/sdc [root@node1 cluster]# ceph-deploy osd create node2 --data /dev/sdb [root@node1 cluster]# ceph-deploy osd create node2 --data /dev/sdc [root@node1 cluster]# ceph-deploy osd create node3 --data /dev/sdb [root@node1 cluster]# ceph-deploy osd create node3 --data /dev/sdc

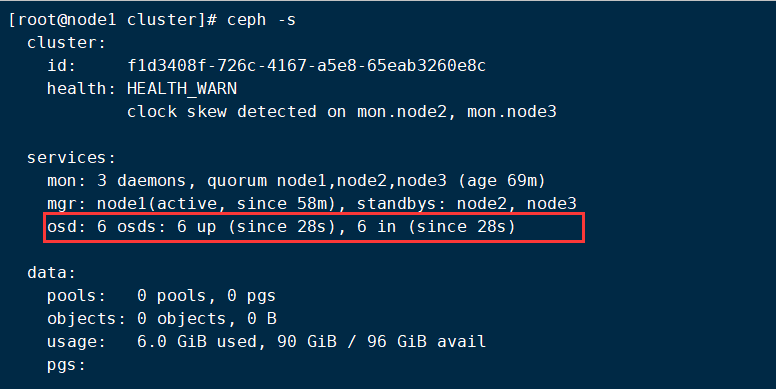

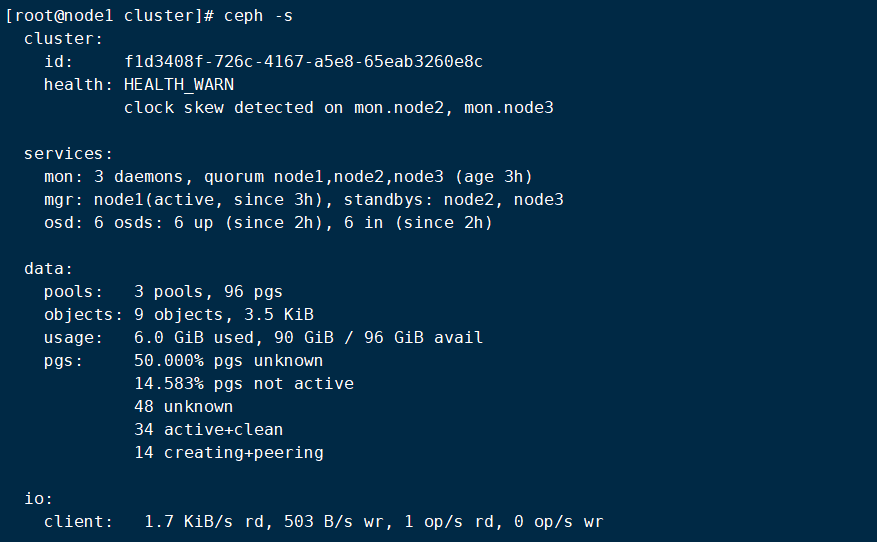

执行完成之后查看状态

13、创建rgw

[root@node1 cluster]# ceph-deploy rgw create node1 node2 node3

查看集群状态

14、创建资源池

[root@node1 ~]# ceph osd pool create rbd 32 32 pool 'rbd' created

创建rbd1为10G

[root@node1 ~]# rbd create --pool rbd --size 10 rbd1

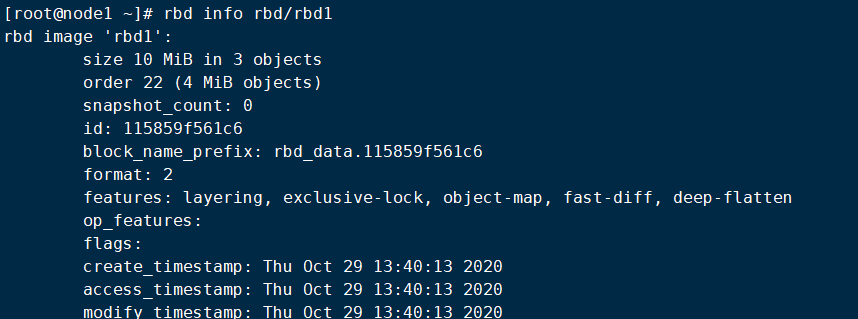

查看rbd1

查看副本数

[root@node1 ~]# ceph osd pool get rbd size size: 3

创建文件系统

[root@node1 ~]# rbd feature disable rbd/rbd1 deep-flatten fast-diff object-map exclusive-lock [root@node1 ~]# rbd map rbd/rbd1

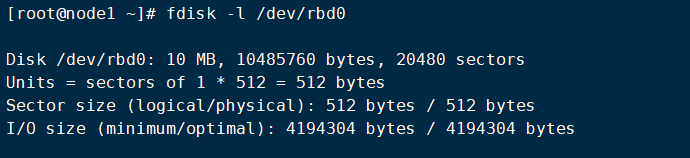

查看文件系统

然后下面就可以分区了,分区这里就不再多说了

ceph集群简单搭建到此结束